SoftNeuro 概要

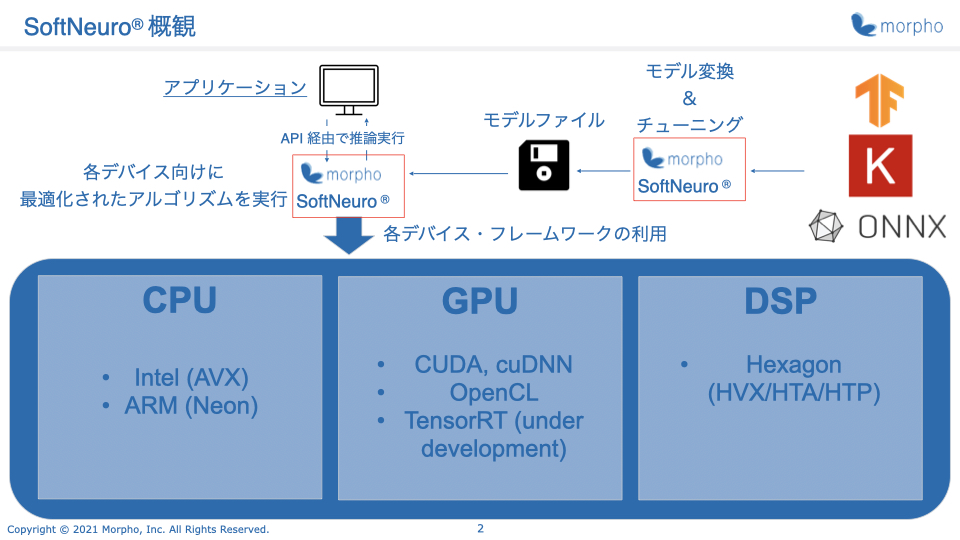

SoftNeuroは学習済みニューラルネットワークの推論処理を、あらゆるプラットフォームで高速に行うためのソフトウェアエンジンです。

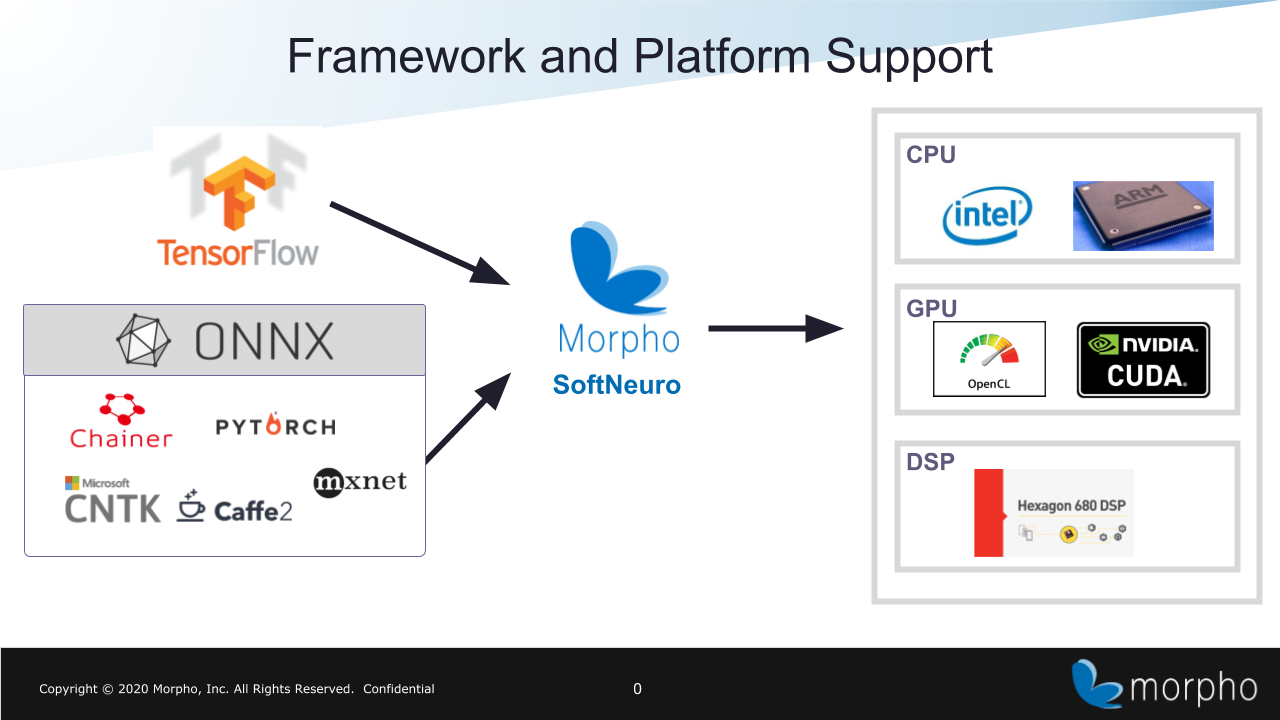

Intel CPU、ARM CPU、Qualcomm DSP(HNN)、NVIDIA GPU(CUDA)、その他のGPU(OpenCL)など、多種多様なプロセッサをサポートしており、

それぞれに対する最適な実装を揃えることによって、あらゆるプラットフォームにおける高速な推論処理を実現しています。

サポート対象とするプラットフォームは今後も拡大していく予定です。

SoftNeuroを利用する際は、一般に広く利用されている深層学習フレームワークのモデルを

SoftNeuro専用の形式(DNNファイル)に変換して推論を実行します。

現在モデル変換機能がサポートしているのはTensorFlow、Keras、ONNXのモデルです。

また、ONNXモデルを経由することでPyTorch、Chainer、Microsoft Cognitive Toolkit、MXNet、PaddlePaddleなどのモデルも利用することが可能です。

また、CLIツールを利用したモデル変換では、高速化のために Layer fusion などのグラフ最適化を行っています。

CLIツールには、モデルの変換や推論だけでなく以下のような機能も用意されています。

詳細はCLIツールマニュアルをご参照ください。

- 推論処理に関する各種統計情報(処理時間、消費メモリ等)の取得

- 推論を実行する環境における特定のDNNモデルの最適な設定を実測値から導出

- DNNファイルの暗号化によるネットワーク構造・レイヤーの重み情報の漏洩防止